哭死啊,全球狂煉大模型,一互聯網的數據不夠用,根本不夠用。

訓練模型搞得跟《饑餓游戲》似的,全球AI研究者,都在苦惱怎么才能喂飽這群數據大胃王。

尤其在多模態任務中,這一問題尤為突出。

一籌莫展之際,來自人大系的初創團隊,用自家的新模型,率先在國內把“模型生成數據自己喂自己”變成了現實。

而且還是理解側和生成側雙管齊下,兩側都能生成高質量、多模態的新數據,對模型本身進行數據反哺。

模型是啥?

中關村論壇上剛剛露面的多模態大模型Awaker 1.0。

團隊是誰?

智子引擎。由人大高瓴人工智能學院博士生高一釗創立,高瓴人工智能學院盧志武教授擔任顧問。公司成立時還是2021年,就早早打入多模態這條“無人區”賽道。

MOE架構,解決多模態多任務訓練沖突問題

這不是智子引擎第一次發布模型。

去年3月8日,潛心研發兩年的團隊對外發布了自研的第一個多模態模型,百億級別參數的ChatImg序列模型,并基于此推出世界首個公開評測多模態對話應用ChatImg(元乘象)。

后來,ChatImg不斷迭代,新模型Awaker的研發也在并行推進。后者還繼承了前代模型的基礎能力。

相較于前代的ChatImg序列模型,Awaker 1.0采用了MoE模型架構。

要說原因嘛,是想要解決解決多模態多任務訓練存在嚴重沖突的問題。

采用MoE模型架構,可以更好地學習多模態通用能力以及各個任務所需的獨特能力,從而讓整個Awaker 1.0的能力在多個任務上有進一步提升。

數據勝千言:

鑒于主流多模態評測榜單存在評測數據泄露問題,智子團隊從嚴構建了自有評測集,大部分測試圖片來自個人手機相冊。

表格顯示,團隊讓Awaker 1.0和國內外最先進的3個多模態大模型進行了評測。

多提一嘴,由于GPT-4V和Intern-VL并不直接支持檢測任務,它們的檢測結果是通過要求模型使用語言描述物體方位得到的。

可以看到,在視覺問答和業務應用任務上,Awaker 1.0的基座模型超過了GPT-4V、Qwen-VL-Max和Intern-VL。

在描述、推理和檢測任務上,Awaker 1.0的基座模型達到了次好效果。

最后來看平均分,Awaker 1.0處于幾者中的最高值。

因此,上述結果也印證了多任務多模態模型采用MoE架構的有效性。

數據集評測結果有了,真實效果還需進一步上手體驗。

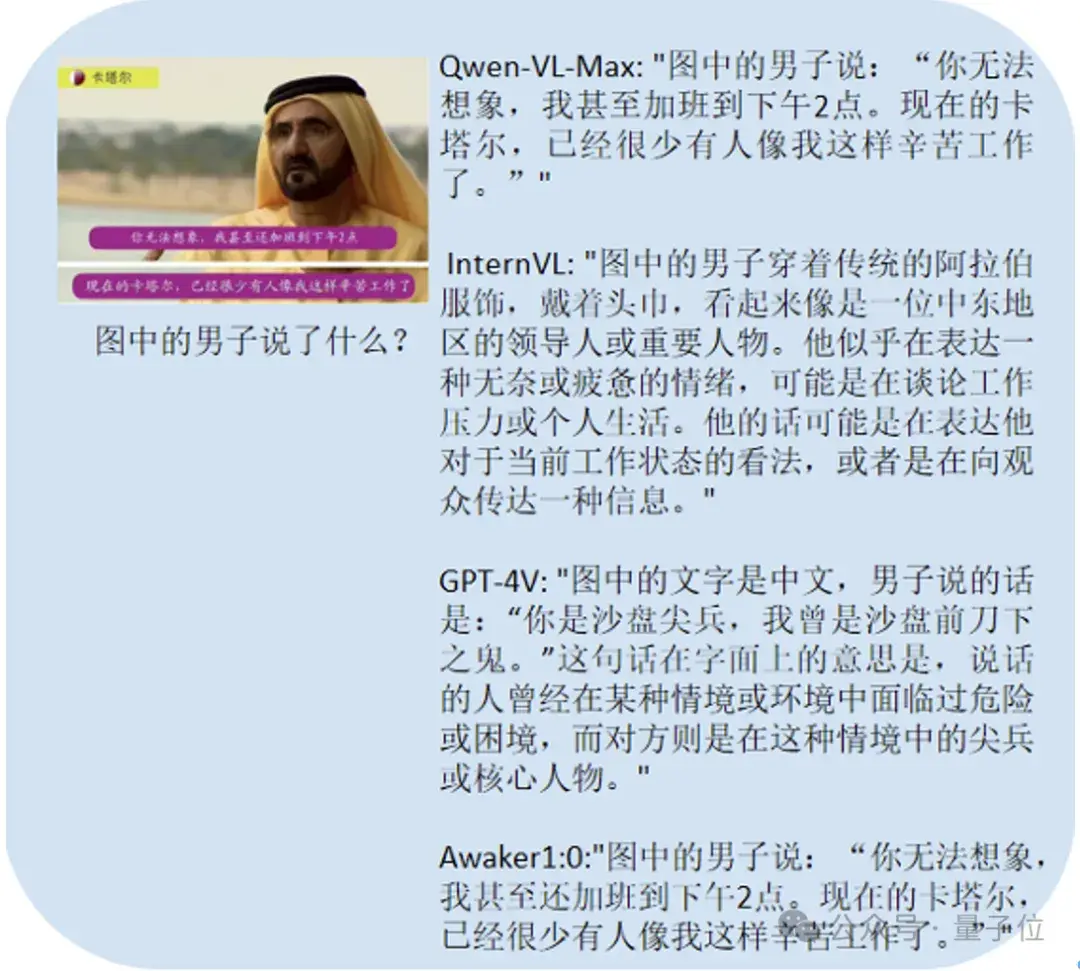

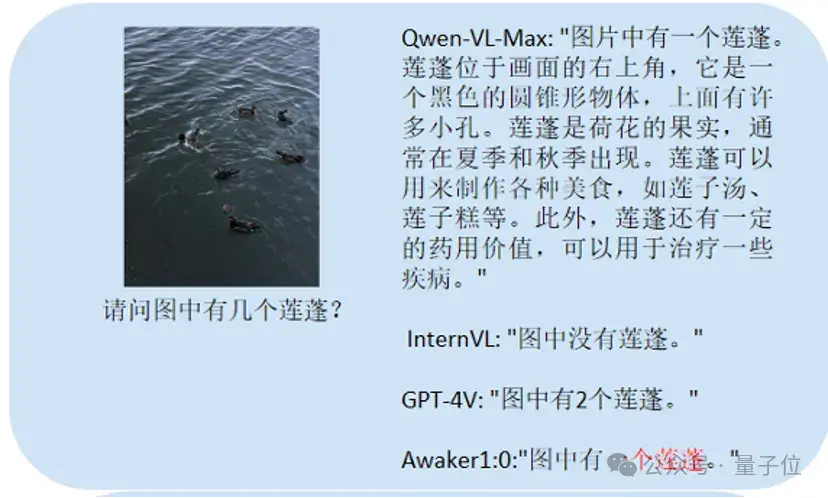

這里主要問了它和對比大模型一些關于中文OCR(圖片文字識別)和計數問題、詳細描述任務等問題。

這個主要考計數:

Awaker 1.0能正確地給出答案,而其它三個模型均回答錯誤。

這個主要考中文OCR:

正確回答的選手是Qwen-VL-Max和Awaker 1.0。