5月18日消息,谷歌DeepMind昨晚推出AI前沿安全框架,并公布技術(shù)報告。

前沿安全框架是一套協(xié)議,強調(diào)了在AI模型發(fā)展過程中識別和緩解潛在風(fēng)險的重要性,旨在主動識別未來可能造成嚴(yán)重傷害的AI能力,并建立檢測和減輕它們的機制。

其計劃是到2025年初全面實施這一初步框架。該框架側(cè)重于模型級別的強大能力(如特殊機構(gòu)或復(fù)雜的網(wǎng)絡(luò)能力)所導(dǎo)致的嚴(yán)重風(fēng)險,對谷歌的一致性研究進行補充。

在技術(shù)報告中,值得關(guān)注的是,保護安全性方面的主要緩解風(fēng)險措施是保護模型權(quán)重,這里的安全似乎更多跟商業(yè)秘密相掛鉤。

一、三大關(guān)鍵組成:識別危害閾值,定期評估檢測,應(yīng)用緩解措施

今天公布的第一版框架建立在谷歌對前沿模型中關(guān)鍵能力評估的研究基礎(chǔ)上,并遵循了負(fù)責(zé)任的能力擴展這一新興方法。

該框架有3個關(guān)鍵組成部分:

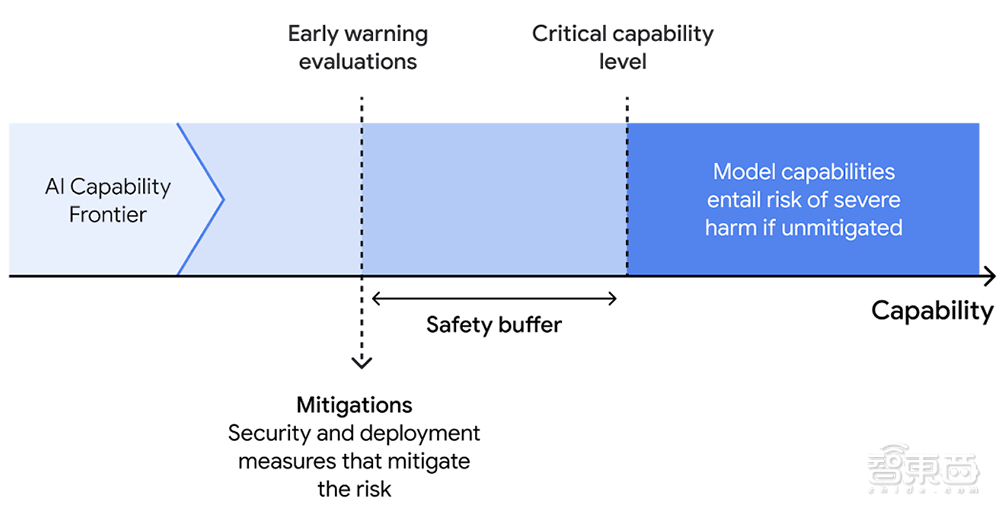

1、識別模型可能具有的嚴(yán)重危害的能力閾值。谷歌DeepMind研究了模型在高風(fēng)險領(lǐng)域中可能造成嚴(yán)重傷害的路徑,然后確定模型在造成這種傷害中必須發(fā)揮作用的最小能力水平,被稱作“關(guān)鍵能力閾值”(CCLs),它們指導(dǎo)了谷歌DeepMind的評估和緩解方法。

2、定期評估前沿模型,以檢測它們何時達(dá)到這些關(guān)鍵能力閾值。谷歌DeepMind將開發(fā)模型評估套件,稱為“早期預(yù)警評估”,當(dāng)模型接近CCL時,它將提醒并頻繁運行,以便研究人員在達(dá)到閾值前注意到。

3、當(dāng)模型達(dá)到早期預(yù)警評估時,應(yīng)用緩解計劃。這應(yīng)考慮到利益和風(fēng)險的總體平衡,以及預(yù)期的部署環(huán)境。這些緩解措施將主要關(guān)注安全性(防止模型泄露)和部署(防止濫用關(guān)鍵能力)。

二、兩類緩解措施管理關(guān)鍵能力,4個領(lǐng)域最有可能造成嚴(yán)重風(fēng)險

前沿安全框架提出了兩類緩解措施:一是防止模型權(quán)重泄露,二是管理對部署中關(guān)鍵能力的訪問并限制其表達(dá)。

對于每一類緩解措施,谷歌DeepMind都制定了若干級別,使其能夠根據(jù)所構(gòu)成的風(fēng)險調(diào)整措施的穩(wěn)健性。

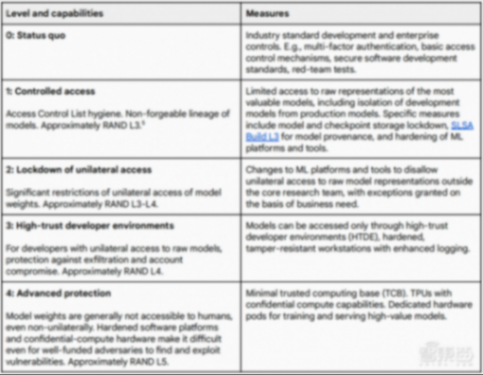

下表描述了可應(yīng)用于模型權(quán)重以防止其泄漏的安全緩解級別。

根據(jù)技術(shù)報告,模型權(quán)重的泄露可能允許移除任何訓(xùn)練到模型中或與模型一起部署的保障措施,并因此訪問(包括不良參與者)任何關(guān)鍵能力。

更高級別的安全緩解可以更好地防止模型權(quán)重的泄露,更嚴(yán)格地管理關(guān)鍵能力。但這些措施也可能減慢創(chuàng)新的速度,并降低能力的廣泛可及性。

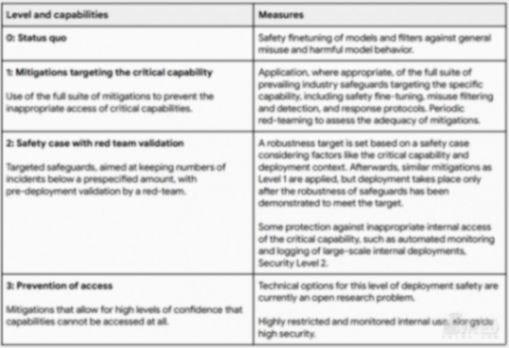

下表描述了部署緩解級別,以管理對部署中關(guān)鍵能力的訪問并限制其表達(dá)。

關(guān)鍵能力的濫用可能或多或少難以與有益的使用區(qū)分開來,并且濫用的總體風(fēng)險可能因部署上下文而異。因此,這里列出的緩解選項是說明性的,需針對不同的用例和風(fēng)險進行調(diào)整。

谷歌DeepMind最初研究表明,未來基礎(chǔ)模型的能力最有可能在這4個領(lǐng)域造成嚴(yán)重的風(fēng)險:自主、生物安全、網(wǎng)絡(luò)安全和機器學(xué)習(xí)研發(fā)。

在自主性、網(wǎng)絡(luò)安全和生物安全方面,其主要目標(biāo)是評估威脅行為者使用具有先進能力的模型進行有害活動并造成嚴(yán)重后果的程度。

對于機器學(xué)習(xí)研發(fā)而言,重點在于具有此類能力的模型是否能夠使具有其他關(guān)鍵能力的模型得以傳播,或者是否能夠使AI能力快速且難以管理地升級。

其技術(shù)報告詳細(xì)介紹了通過對自主性、生物安全、網(wǎng)絡(luò)安全和機器學(xué)習(xí)研發(fā)風(fēng)險領(lǐng)域的初步分析確定的一組初始CCL。