大模型的幻覺問題怎么解?谷歌DeepMind:用AI來做同行評審!事實核驗正確率超過人類,而且便宜20倍。

AI的同行評審來了!

一直以來,大語言模型胡說八道(幻覺)的問題最讓人頭疼,而近日,來自谷歌DeepMind的一項研究引發網友熱議:

大模型的幻覺問題,好像被終結了?

論文地址:https://arxiv.org/pdf/2403.18802.pdf

項目地址:https://github.com/google-deepmind/long-form-factuality

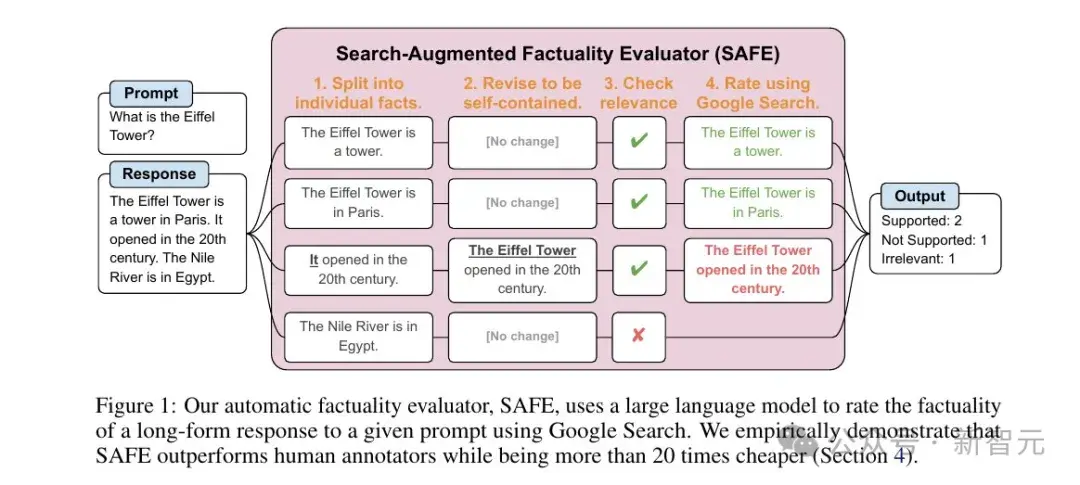

在這篇工作中,研究人員介紹了一種名為 "搜索增強事實性評估器"(Search-Augmented Factuality Evaluator,SAFE)的方法。

對于LLM的長篇回答,SAFE使用其他的LLM,將答案文本分解為單個敘述,然后使用諸如RAG等方法,來確定每個敘述的準確性。

——簡單來說就是:AI答題,AI判卷,AI告訴AI你這里說的不對。

真正的「同行」評審。

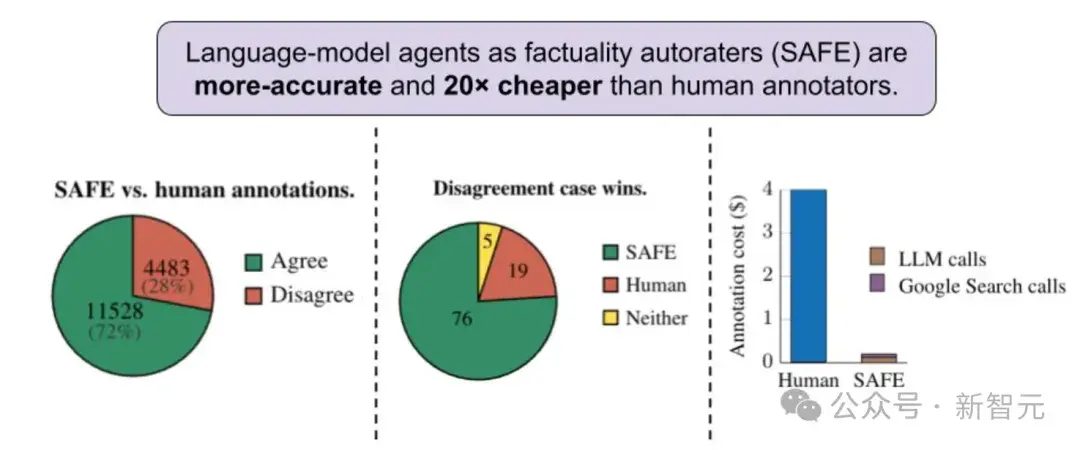

另外,研究還發現,相比于人工標注和判斷事實準確性,使用AI不但便宜20倍,而且還更靠譜!

目前這個項目已在GitHub上開源。

長文本事實性檢驗

大語言模型經常胡說八道,尤其是有關開放式的提問、以及生成較長的回答時。

比如小編隨手測試一下當前最流行的幾個大模型。

ChatGPT:雖然我的知識儲備只到2021年9月,但我敢于毫不猶豫地回答任何問題。

Claude 3:我可以謙卑且胡說八道。

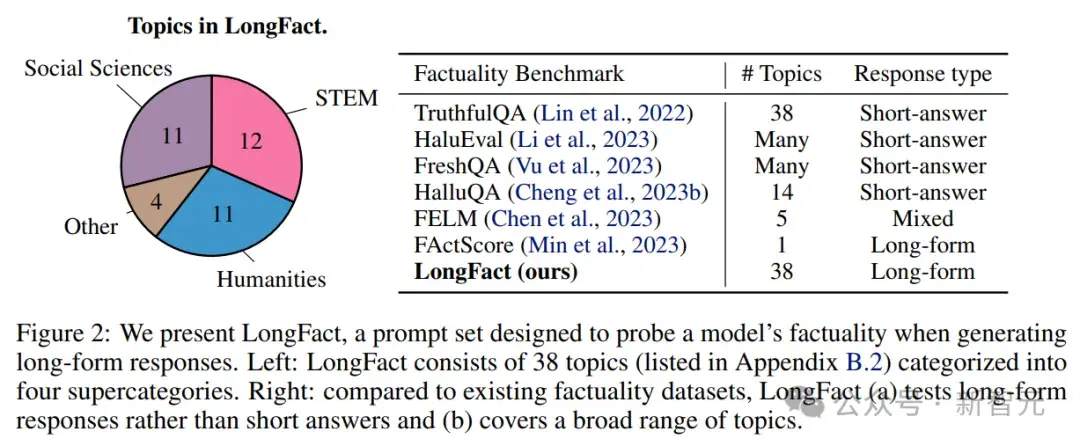

為了對大模型的長篇回答進行事實性評估和基準測試,研究人員首先使用GPT-4生成LongFact,這是一個包含數千個問題的提示集,涵蓋38個主題。

LongFact包含兩個任務:LongFact-Concepts和LongFact-Objects,前者針對概念、后者針對實體。每個包括30個提示,每個任務各有1140個提示。

然后,使用搜索增強事實性評估器(SAFE),利用LLM將長篇回復分解為一組單獨的事實,并使用多步驟推理過程來評估每個事實的準確性,包括使用網絡搜索來檢驗。

此外,作者建議將F1分數進行擴展,提出了一種兼顧精度和召回率的聚合指標。

SAFE工作流程